説明可能なAI

はじめに

「説明可能なAI」とは

「説明可能なAI」(“Explainable AI” または “XAI”とも表記されます)とは、一言で言うと

「何を根拠にそのように判断したか、そのような答えを出したか」が「(人間が)理解できる」AIのことです。

近年広く使用されているディープラーニングなどの機械学習の多くは、基本的には説明可能ではありません。

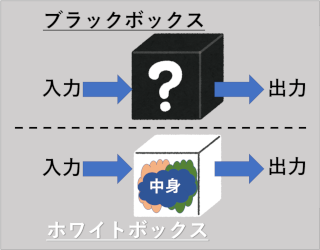

「ブラックボックス」と「ホワイトボックス」

あるAIが、説明可能か否かは、換言するとそのAIがブラックボックスかホワイトボックスか、とも表現できます。

図:ブラックボックスとホワイトボックス

ブラックボックス、ホワイトボックスは、どちらも

【入力を入れると中で何かしらの処理を行い、出力を出す箱(実体はソフトウェアなど)】

なのですが、

- 箱の中身が外側から見えておらず、中身が理解できないのがブラックボックス

- 箱の中身が外側から見えており、中身が理解できるのがホワイトボックス

です。

したがいまして、端的に言うと「説明可能なAI」は「ホワイトボックス」です。

AIのニーズはブラックボックスからホワイトボックスへ

次に、説明可能なAIへのニーズについてご説明します。

例えば、病院において医師が(説明可能でない)診断AIにより人命に関わる判断を行った場合、

「どうしてそのような判断をしたのか」が医師が分からないとすると、

医師は、AIの判断を信頼することも患者に診断の根拠を説明することもできません。

したがって、特に重要な判断をするAIについては、判断の根拠がユーザに理解できること、

すなわちブラックボックスのホワイトボックス化が求められています。

説明可能なAIの実例

次に、説明可能なAIの開発例をご紹介します。

農研機構 画像の特徴を可視化できる新しいAIを開発

(以下、佐藤による概要まとめです)

病害虫による農作物の被害への対策として、病害虫の自動判別システムの開発が進められているが、今回は説明可能なAIへの社会的要請を鑑み、判断の根拠となる画像の特徴を可視化できるAIを開発した。

具体的には、AIでジャガイモの葉の画像を学習、判断する時に、葉の特徴(病気/健全)を画像として可視化し、人間はそれを見ることによってAIの判断の根拠を理解することが可能。

(その他、詳細につきましてはリンク先をご参照ください)

おわりに

「説明可能なAI」とはどういうものか、おわかりいただけたでしょうか。

私も、何を考えているかが周りの人にとって分かりやすい「説明可能なヒト」でありたいと思います。

ではまた。

- 当ページの人物画像はNIGAOE MAKERで作成しました。